Фотографии в почти полной темноте — один из самых сложных сценариев для любой камеры. Вы наверняка сталкивались с этим сами: кадр вроде бы получился, но вместо деталей на фото сплошное зерно, шум и странная каша из цветов. Apple решила подойти к проблеме радикально и показала исследование, которое может сильно изменить подход к ночной съёмке на iPhone в будущем.

Apple готовится всерьез прокачать ночной режим съемки на iPhone

❗ПОДПИСЫВАЙСЯ НА НАШ КАНАЛ В ДЗЕНЕ И ЧИТАЙ КРУТЫЕ СТАТЬИ БЕСПЛАТНО

Проблема экстремально низкой освещённости хорошо известна. Когда на матрицу попадает слишком мало света, сенсор просто не получает достаточной информации. Классические алгоритмы обработки пытаются вытянуть изображение, подавляя шум и усиливая сигнал, но часто делают это слишком агрессивно. В результате фото выглядит замыленным, как будто его нарисовали маслом, а мелкие детали либо исчезают, либо превращаются во что-то неузнаваемое.

Чтобы решить эту задачу, исследователи Apple совместно с Purdue University разработали модель под названием DarkDiff. Ключевая идея здесь в том, что искусственный интеллект работает не после съёмки, а прямо внутри цепочки обработки изображения камеры. То есть ИИ становится частью ISP, того самого мозга, который превращает сырые данные с сенсора в финальное фото.

В отличие от привычных моделей, которые просто пытаются минимизировать разницу между пикселями, DarkDiff использует диффузионный подход. Проще говоря, модель опирается не только на то, что видит сенсор, но и на своё понимание того, как в реальности выглядят сцены, объекты и текстуры. Для этого Apple адаптировала предобученную диффузионную модель, похожую по принципу на Stable Diffusion, и встроила её в процесс обработки изображения.

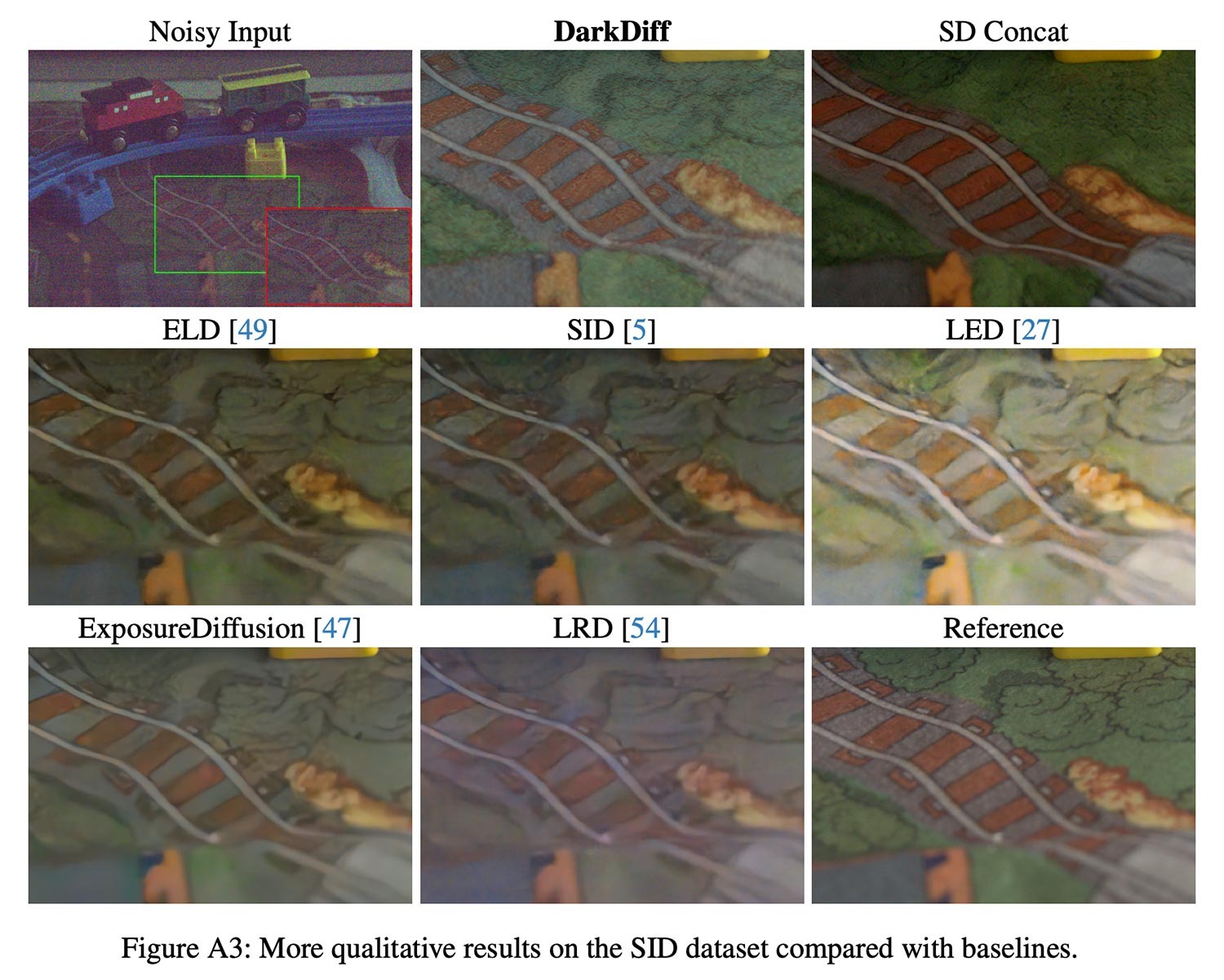

Сравнение DarkDiff с другими режимами съемки. Результат получается отличным. Изображение: 9to5mac.com

Работает это так. Сначала классический ISP выполняет базовые операции вроде баланса белого и демозаики, превращая сырые данные сенсора в линейное RGB-изображение. Затем в дело вступает DarkDiff. Он очищает изображение от шума и сразу формирует финальную версию в sRGB, стараясь сохранить реальные структуры, а не дорисовывать лишнего.

Отдельное внимание уделено борьбе с галлюцинациями, когда ИИ начинает придумывать детали, которых не было. Для этого используется механизм локального внимания, который анализирует небольшие участки изображения и помогает сохранять их форму и содержание. Также применяется настройка силы следования входным данным. При более мягких параметрах изображение получается сглаженным, при более жёстких появляются резкие текстуры и детали, но возрастает риск артефактов.

❗ПОДПИСЫВАЙСЯ НА ТЕЛЕГРАМ-КАНАЛ СУНДУК АЛИБАБЫ, ЧТОБЫ ПОКУПАТЬ ТОЛЬКО ЛУЧШИЕ ТОВАРЫ С АЛИЭКСПРЕСС

Тестировали DarkDiff на реальных ночных снимках, сделанных при экстремально коротких выдержках, вплоть до 0,033 секунды. Полученные результаты сравнивали с эталонными фотографиями, снятыми с выдержкой в сотни раз длиннее и со штатива. Визуально разница впечатляет. Там, где обычные алгоритмы показывают шум и пятна, DarkDiff возвращает читаемые формы, цвета и детали.

При этом Apple честно указывает на ограничения. Такой подход требует серьёзных вычислительных ресурсов и в текущем виде вряд ли подойдёт для постоянной локальной обработки на смартфоне без заметного удара по батарее. Вероятно, подобные технологии сначала появятся либо в облаке, либо в сильно упрощённом виде. Есть и проблемы с распознаванием текста в тёмных сценах, особенно не на английском языке.

Интересно, когда новая нейросеть появится на iPhone. Изображение: idropnews.com

Важно понимать, что это исследование, а не анонс новой функции камеры iPhone. Но оно наглядно показывает, в каком направлении Apple двигается. Физические ограничения камер смартфонов никуда не денутся, а значит, будущее мобильной фотографии всё больше будет зависеть от вычислений и умного софта. И если такие технологии дойдут до серийных устройств, ночные фото на iPhone могут выглядеть совсем иначе, чем мы привыкли сегодня.